Koniec z fałszywymi nagraniami polityków tworzonymi przez SI. Google chce uzdrowić kampanię

Jednym z najgroźniejszych przejawów wybuchu zainteresowania rozwojem sztucznej inteligencji są deepfake’i, dzięki którym fabrykować można dowolną wypowiedź, by później przypisywać ją osobie, z której ust dane słowa nigdy nie padły. W ostatnim czasie podobne praktyki zaczęły być wykorzystywane także na polskim politycznym podwórku. Choć nie brakuje głosów, że walkę z deepfake’ami jest już za późno, odpór manipulacjom chce dać Google.

Niebezpieczny precedens PO

O sprawie manipulacji z użyciem generowanego maszynowego głosu informowaliśmy pod koniec sierpnia. Wówczas na kontach Platformy Obywatelskiej w mediach społecznościowych pojawił się kontrowersyjny materiał, w którym głosem Mateusza Morawickiego są odczytywane wypowiedzi z maili udostępnianych przez serwis Poufna Rozmowa. Problem w tym, że Morawiecki słów tych nigdy nie wypowiedział, zaś nagranie audio było wygenerowane maszynowo na podstawie ogólnodostępnych próbek jego głosu z innych wystąpień. Do dziś także nie usunięto, ani nie poprawiono materiału z oficjalnego konta PO na Twitterze.

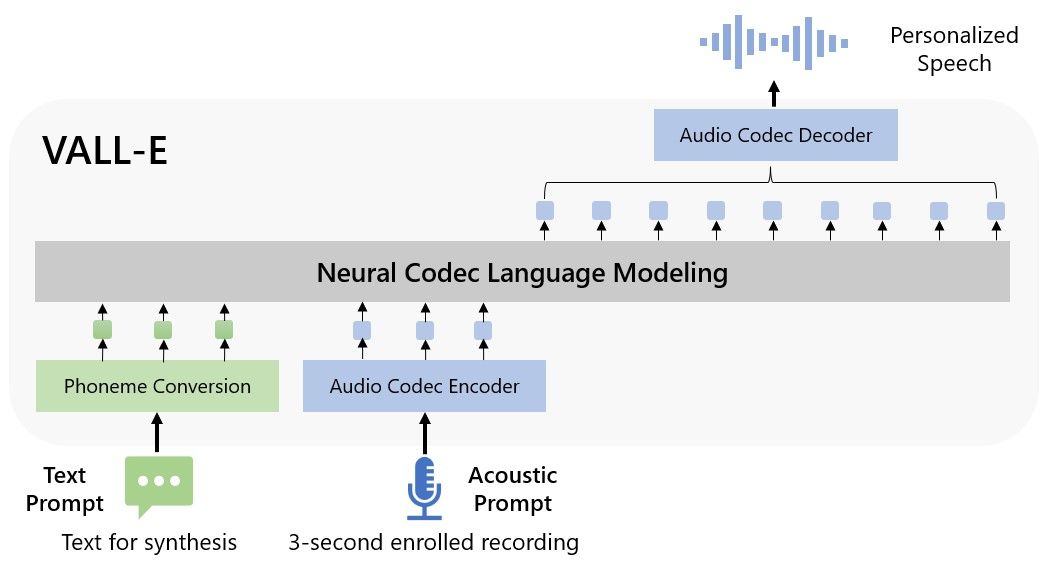

Taka procedura jest możliwa z użyciem np. silnika VALL-E, który przetwarza tekst na mowę. Sam proces znany jest oczywiście od lat, niemniej VALL-E i jemu podobne narzędzia wyniosły go na nowy poziom: dzięki silnikowi bazującemu na sieci neuronowej z niebywałą skutecznością można wygenerować wypowiedź z użyciem głosu dowolnej prawdziwej osoby. Szokuje łatwość, z jaką cały proces się odbywa. Dotąd, aby uzyskać podobny rezultat, potrzebne były wielogodzinne i skomplikowane sesje nagraniowe z lektorami. Do podszycia się pod kogokolwiek dzięki VALL-E wystarczy zaledwie 3-sekundowe nagranie z próbką głosu, które służy jako koder sygnału wyjściowego. To właśnie z użyciem narzędzi klasy VALL-E PO opracowało deepfake z wypowiedziami premiera.

Deepfake coraz doskonalszy

Sprowadziło to na partię fale krytyki. Nie dość bowiem, że PO zaczęło przekonywać, że Morawiecki udzielił wypowiedzi, która nigdy nie padla, to jeszcze odbiorca nagrania nie był w żaden sposób informowany o tym, że głos premiera jest wygenerowany maszynowo. Dzięki użyciu tzw. dyskretnego kodeku modelowania językowego jakość naśladownictwa głosu Mateusza Morawieckiego, była natomiast tak wysoka, że dla niepoinformowanego odbiorcy mogło być trudno stwierdzić fałsz. Dopiero po solidnej reprymendzie użytkowników Twittera i nie tylko Platforma Obywatelska zamieściła pod fałszywym nagraniem lakoniczny komentarz: „Lektor wygenerowany przez AI”.

Największa partia opozycji, zdając sobie sprawę, że suche maile nie robią takiego wrażenia jak nagrania audio i wideo, chciała uzyskać efekt podobny do tego, który pozbawił ją władzy w roku 2015. Pomysł okazał się wybitnie chybiony, a działania PO uznano za niebezpieczny precedens, który może zachęcić naśladowców i negatywnie wpłynąć na wiarygodność całej kampanii. Co prawda dysponujemy narzędziami pozwalającymi stwierdzić, czy dane nagranie to deepfake, niemniej trudno oczekiwać umiejętności ich obsługi od każdego wyborcy. Zwłaszcza że fałszywe nagrania, zwłaszcza audio, są z miesiąca na miesiąc coraz doskonalsze i coraz trudniejsze w identyfikacji

Pełnowymiarowa walka z deepfake’ami

Równie negatywne nastawienie ma Google, a więc korporacja, która ma relatywnie dużą władzę nad tym, jakie treści z globalnego WWW trafiają do użytkowników i w jaki sposób są dostarczane. Przed rozpoczęciem kampanii prezydenckiej w USA Google chce uruchomić system identyfikacji treści wygenerowanych przez silniki wykorzystujące sieci neuronowe. Korporacja spodziewa się niezwykle agresywnej walki pomiędzy kandydatami, w której jeśli nie sztaby wyborcze, to oddani wyborcy nie będą mieli zahamowań przed posługiwaniem się sfałszowanymi nagraniami audio, ale też wideo.

Google skupi się w pierwszej kolejności na automatycznym sprawdzaniu wszystkich treści reklamowych pochodzących od komitetów wyborczych pod kątem prób dostarczania w nich deepfake’ów. Jeśli ich obecność zostanie potwierdzona, wówczas konieczne będzie odpowiednie oznaczenie takiej treści. Komentatorzy są zgodni, że dość liberalne podejście – Google mogłoby całkowicie zakazać stosowania deepfake’ów w materiałach wyborczych, a decyduje się tylko na wymuszanie ich oznaczania, co – mogłoby się wydawać – powinno być oczywistością.

Jak będzie działać weryfikacja?

Według Allie Bodack, rzeczniki Google, korporacja już teraz dysponuje narzędziami, które będą w stanie wychwytywać fałsz z wysoką skutecznością. Taka argumentacja może przekonywać. Google nie jest w stanie przeskanować pod kątem politycznych deepfake’ów całego internetu czy choćby kilkugodzinnej aktywności w dowolnym serwisie społecznościowym, a jeśli będzie dysponować ściśle określonym i ograniczonym zakresem treści do przeanalizowania, w tym przypadku wykupionych w jej usługach reklam kampanijnych, przedsięwzięcie może się przynajmniej częściowo udać. Wiemy już, że Google pracuje nad systemem niewidzialnych dla ludzkiego oka znaków wodnych, które algorytmy mogą wykorzystywać do stwierdzania deepfake’ów.

Niestety, beneficjentem mechanizmu weryfikowania wiarygodności nie będą Polacy. Przynajmniej nie w najbliższych wyborach parlamentarnych. Google zamierza uruchomić system dopiero w listopadzie, czyli na rok przed tym, jak elektorzy wybiorą kolejnego prezydenta Stanów Zjednoczonych.